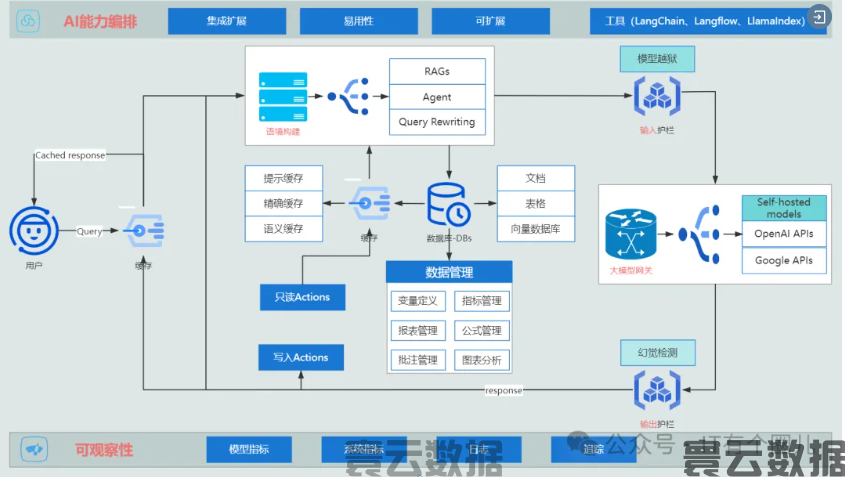

我们一直惊叹于AI能写文章、能做画、会编程,现在还能生成视频。从宏观上来看,一个完整的通用AI系统如下图所示,在最关键的模型网关处,调用我们已经训练好的模型,进行用户数据交互,反馈最终的结果。所以,结果的好坏,就取决于我们模型的能力水平,因此,2024年我们看到了市场上千模大战的场面,模型的泛化能力正在以天为单位高歌猛进。

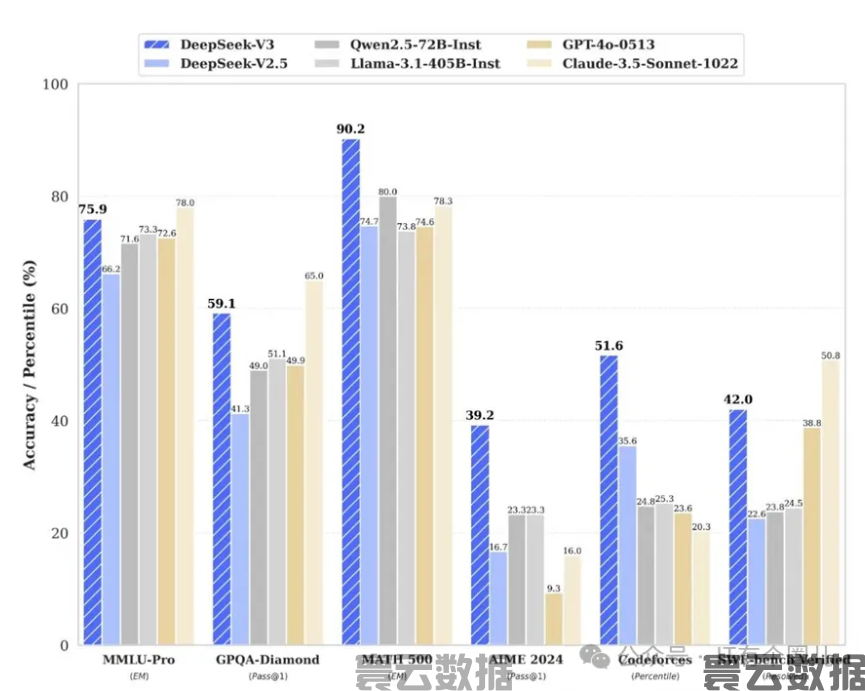

如何让你的模型,在各项能力上超越对手,不管是在应用的感官上,还是行业的各类指标上都胜人半子,模型的训练被提到了前所未有的高度。深度求索在短短两个月内使用英伟达H800 GPU数据中心就训练出了DeepSeek-V3模型,花费了约558万美元。其训练费用相比OpenAI的GPT-4等目前全球主流的大模型要少得多的多,DeepSeek“AI界拼多多”也由此得名。

DeepSeek性能测评

所有的AI大厂都在卷训练,从质量、价格、性能(每秒生成的Token数以及首个Token生成时间)、上下文窗口等多方面来评测训练的成果。那么问题来了:

什么是AI模型训练?

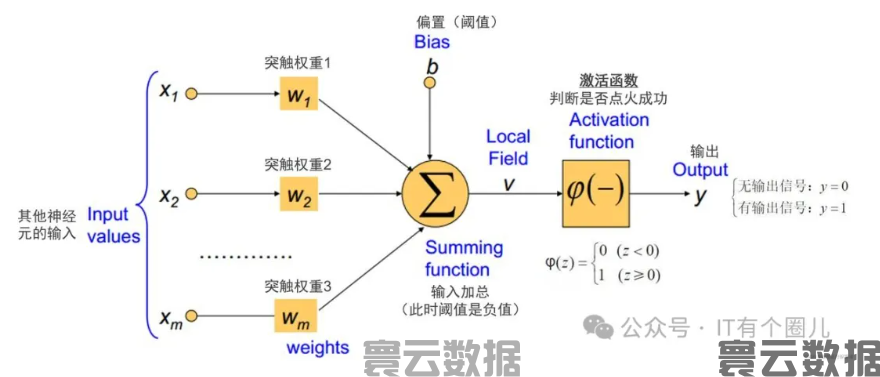

AI模型训练实质上是利用数据驱动的方法,使人工智能系统能够从经验数据中自主学习,并针对特定任务进行高效预测、分类或内容生成。此过程的核心在于通过优化算法调整模型内部参数(例如,在神经网络中的权重和偏置),以最小化模型输出与实际目标值之间的误差或损失函数。这样做的目的是为了提高模型的泛化能力,使其在未见过的数据集上也能保持出色的性能。

AI模型训练在训练什么?

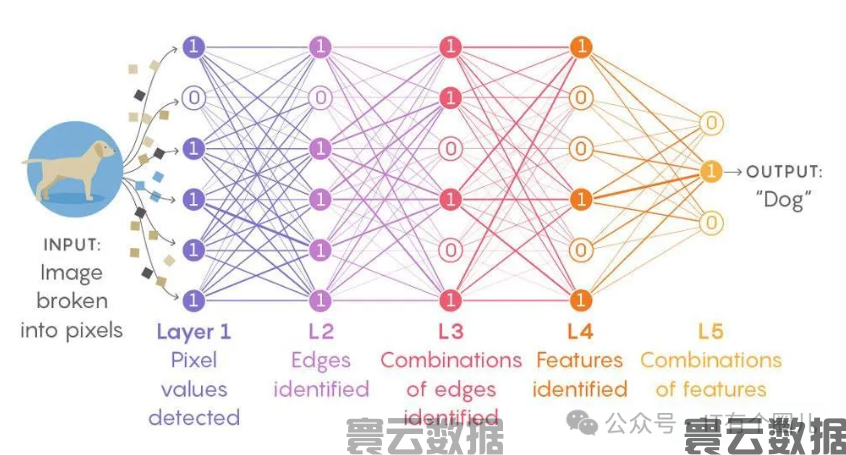

我们来看一个图片识别的训练过程,怎么把一张狗的图片识别并输出“Dog”这个单词的。

这张图展示了一个典型的卷积神经网络(Convolutional Neural Network, CNN)如何处理图像识别任务的过程。

权重调整: 通过训练,网络不断调整各层之间的权重,以优化特征提取和分类性能。

这种分层结构使得CNN能够有效地处理图像数据,基于特征和权重,最终实现较高可信度的识别结果。经过不断地验证(训练的一个环节),添加更多层会比在每层中添加更多神经元获得更多的性能提升,所以如果把上面的5层结构增加到100层,将更大程度提高识别的可信度,当然,资源的消耗(算力)也将几何倍的增长。

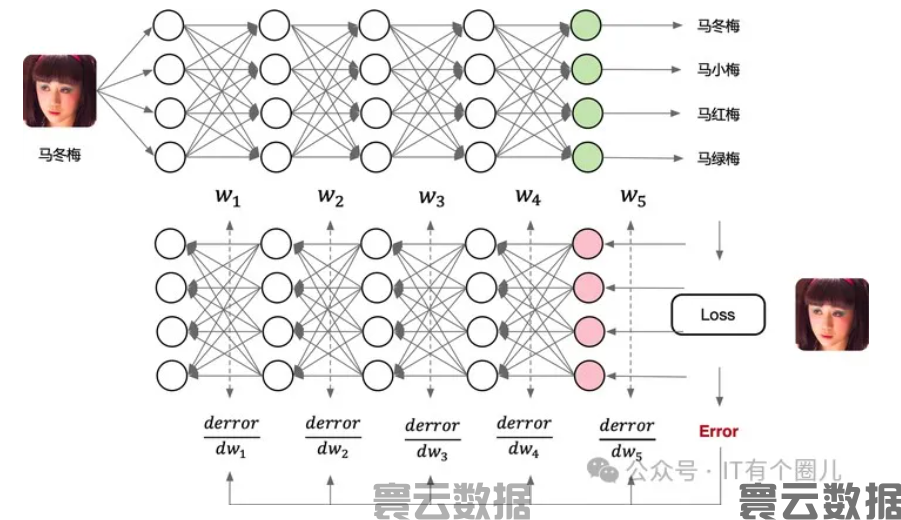

假设上面这个模型我们拿来测试人脸的识别,看看识别的准确性上怎么样,我们大概率会得到下面的结果

这依然是一个5层的结构,最后一层给出最终的分类结果。在这个例子中,网络识别出输入图像为“马冬梅”。输出层通常使用softmax函数将神经元的输出转化为概率分布,从而确定最有可能的类别。在测试过程中,我们不需要调整权重,但可以计算预测结果与实际标签之间的损失(如果已知真实标签,比如我们知道图片是马冬梅,看看模型能不能识别正确),通过损失函数用于评估模型的预测准确性,虽然在测试阶段不进行权重更新,但可以通过反向传播计算每个权重对损失的贡献(即梯度),从而来分析模型的性能。

训练原理涉及到使用大量的标注数据样本(狗的图片)作为输入,通过前向传播计算当前模型配置下的输出误差,再利用反向传播算法根据误差梯度调整各层之间的连接权重。这个迭代过程持续进行,直到找到一组最优或接近最优的参数设置,使得模型在验证集上的表现达到我们满意的水平。为了避免过拟合等常见问题,还会采用正则化、dropout等多种技术手段来增强模型的稳定性和泛化能力。总之,整个训练过程是一个精密设计的参数搜索过程,最终实现模型在指定任务上的最佳性能。

如何保证模型训练的质量?

互联网大厂天然具备海量数据的优势,AI公司在互联网上获取大量训练数据,但是,现如今的互联网本就充斥着各种各样用AI生产出来的数据。保守估计,到2026年,90%的互联网数据将由AI生成。这种 “污染” 使得从训练数据集中彻底过滤AI输出将会变得越来越困难。

要确保AI模型在行业的领先地位,高质量的数据是必不可少的,九尺高台始于垒土,高质量的数据是成功训练模型的基础。产品要确保训练的数据集具有代表性、准确性和完整性。在程序进行数据处理时需要提前进行清洗,包括去除噪声、处理缺失值、异常值等。同步在训练过程中,加强对数据进行标准化或归一化处理,使得不同特征之间具有可比性,这有助于加速模型收敛并提高性能。此外,还需要进行数据增强(如旋转、缩放、裁剪等)以增加数据多样性,特别是在图像处理任务中,将会给你带来意想不到的收获。

免责声明:寰云数据遵守行业规则,本站所转载的稿件都标注作者和来源。 转载稿件或作者投稿可能会经编辑修改或者补充. 如有异议可投诉至: hydatapb@yundatas.com